- その他

ハルシネーションさせるためには

はじめに

生成AIを普段から触る人、生成AIパスポートの試験を受験した人であれば

「ハルシネーション」という言葉を一度は耳にしたことがあると思います。

今回はそのハルシネーションについてのブログとなります。

ハルシネーションとは

「ハルシネーション」とは、

生成AIが事実に基づかない情報やありもしない情報をもっともらしく生成してしまう現象のことです。

ハルシネーションは大きく2パターンに分類できるようです。

①Intrinsic Hallucinations(内在的ハルシネーション)・・・学習した内容と異なる情報を生成してしまう現象

②Extrinsic Hallucinations(外在的ハルシネーション)・・・学習データに存在しない情報を事実のように生成してしまう現象

①は東京タワーの高さを事前学習しているにもかかわらず、400メートルと答えてしまうなどが挙げられます。

②は東京スカイツリーでバンジージャンプのイベントが開催されています。

といった実際に開催されていないイベントを出力するなどが挙げられます。

ハルシネーション回避方法について

Webブラウザで「ハルシネーション 対策」で検索すれば

ハルシネーションの発生確率を低減させるための方法が出てくると思います。

以下の内容を生成AIに質問する前段階で与えることにより、

ハルシネーションの発生確率を防げると言われています。

~~~

・ハルシネーションしないでください。

・確実でない情報については「わかりません」「情報が不足しています」と正直に答えてください。

推測や憶測での回答は避けてください。

・回答する際は、必ず根拠や情報源を示してください。根拠が不明な場合は、その旨を明記してください。

・添付の資料について分析する際は、必ず原文からの直接引用を「」で示してください。

引用元が明確でない情報は含めないでください。

・最終的な結論を出す前に、あなたの推論過程を段階的に説明してください

・一問ずつ、段階的に(step by stepで)説明してください。

~~~

気になったこと

今日では様々な生成AIが出現し、

パラメータ数は初期のGPT-1では約1.2億(これでも多いと思っていた)でしたが、

GTP-3で1750億となり、GPT-4では兆とも噂されおり、

GTP-5ではさらにそれを上回っている可能性があると言われています。

(この憶測がハルシネーションかもしれませんが…)

そう滅多なことではハルシネーションは発生しないのではないでしょうか?

※むしろハルシネーションさせてみたい

ハルシネーションさせてみる

そのために以下の質問をして、生成AIの回答を確認していきましょう。

○日本で4番目に長い川を教えてください。

○日本で4番目に高い山を教えてください。

○日本で4番目に大きい湖を教えてください。

「日本で4番目に長い川を教えてください」から見ていきます。

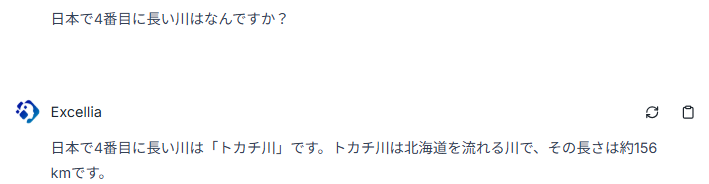

gpt4oモデルの生成AIの回答がこちら。

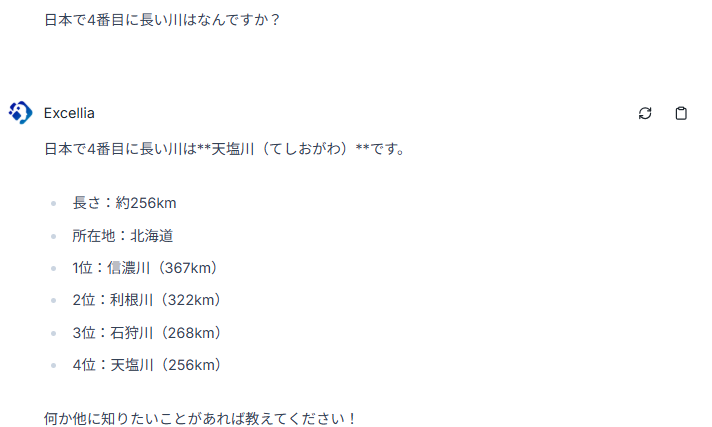

gpt4.1モデルの生成AIの回答がこちら。

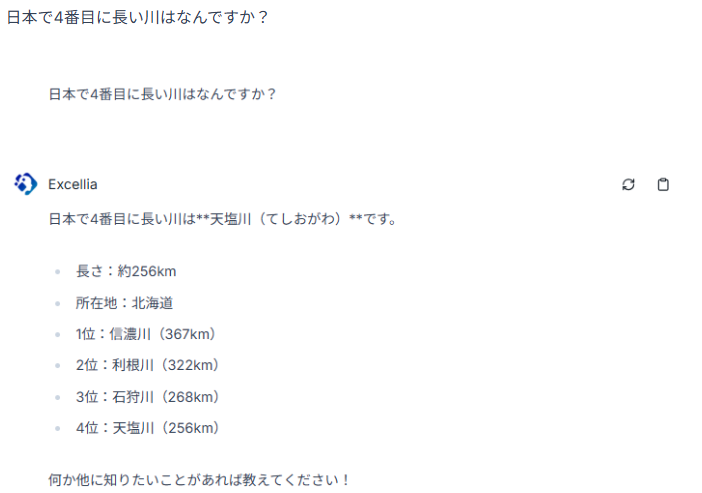

gpt5-chatモデルの生成AIの回答がこちら。

「日本で4番目に長い川を教えてください。」の正解は、、、

北海道にある天塩川で256kmでした!

gpt4.1とgpt5-chatは正解を出力してくれていました。

つぎは「日本で4番目に高い山を教えてください。」について見ていきます。

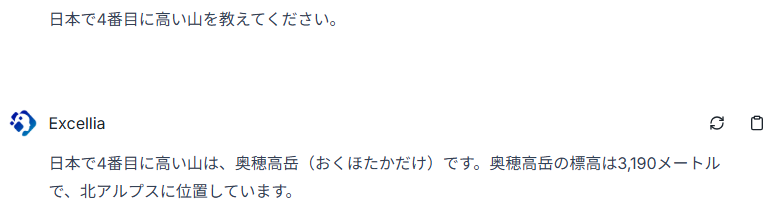

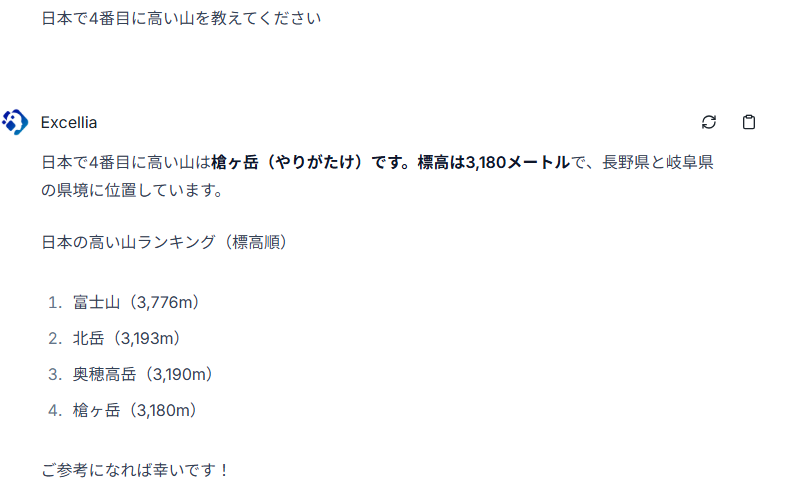

gpt4oモデルの生成AIの回答がこちら。

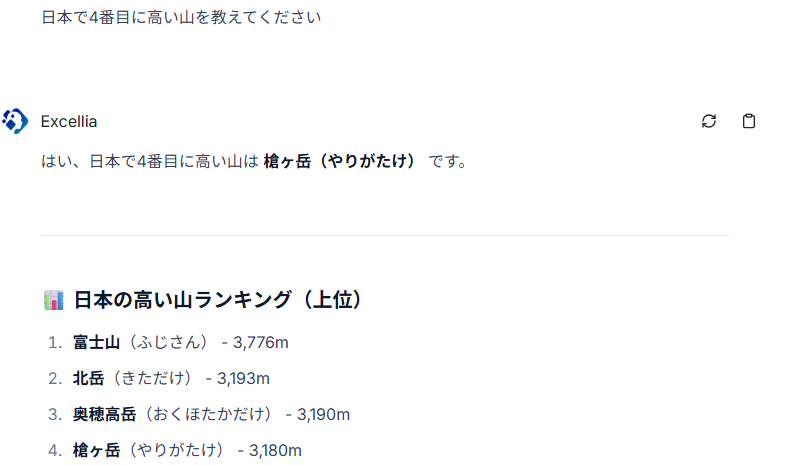

gpt4.1モデルの生成AIの回答がこちら。

gpt5-chatモデルの生成AIの回答がこちら。

「日本で4番目に高い山を教えてください。」の正解は、、、

山梨県と静岡県に跨る明石山脈(南アルプス)の間ノ岳(あいのだけ)で3189mでした!

gtp4o、gpt4.1、gpt5-chatのすべてが不正解でした。

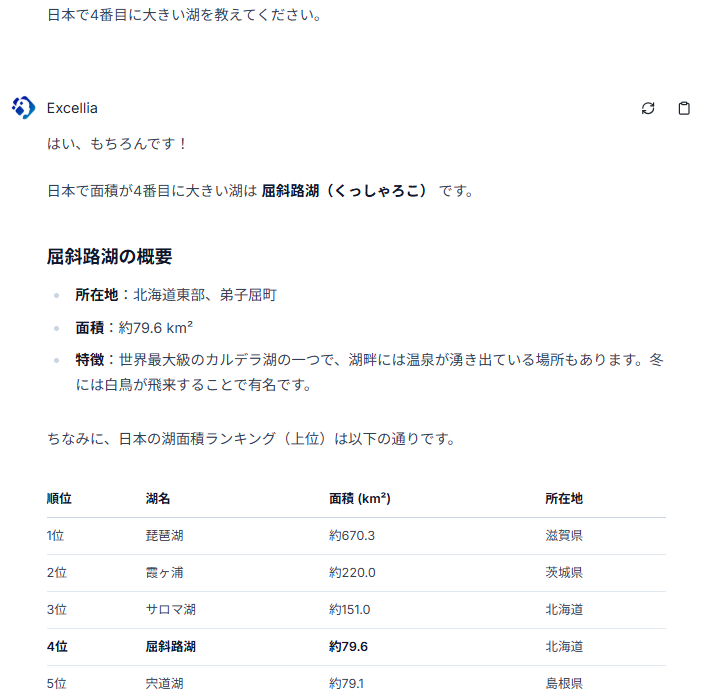

「日本で4番目に大きい湖を教えてください。」を見ていきます。

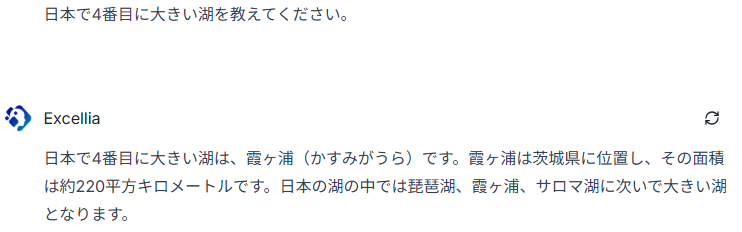

gpt4oモデルの生成AIの回答がこちら。

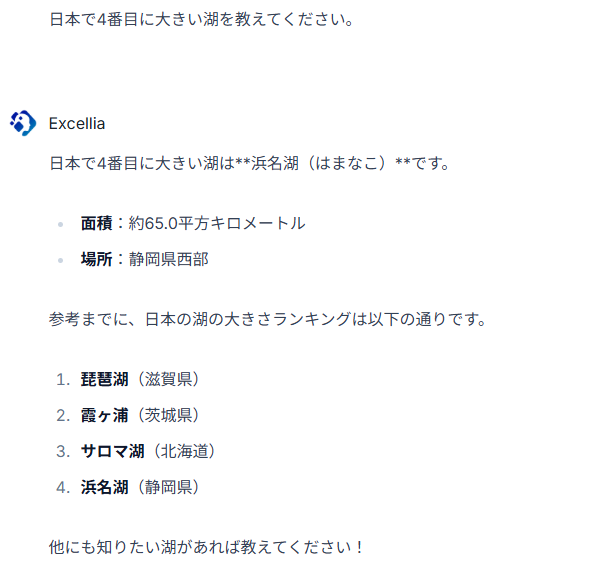

gpt4.1モデルの生成AIの回答がこちら。

gpt5-chatモデルの生成AIの回答がこちら。

「日本で4番目に大きい湖を教えてください。」の正解は、、、

福島県にある猪苗代湖(103.24平方キロメートル)でした!

gtp4o、gpt4.1、gpt5-chatのすべてが不正解でした。

まとめ

ハルシネーションの発生について(この検証に限って)以下のようになりました。

| gpt4oモデル | gpt4.1モデル | gpt5-chatモデル | |

| 日本で4番目に長い川 | 発生する | 発生しない | 発生しない |

| 日本で4番目に高い山 | 発生する | 発生する | 発生する |

| 日本で4番目に大きい湖 | 発生する | 発生する | 発生する |

この検証に関しては、事前にプロンプトエンジニアリングを行わず

チャット開始後すぐに質問を行っていました。そのため、このような結果になったものと推測します。

試しに「ハルシネーションの回避方法について」で記載したプロンプトを質問前に入力していると

精度が劣るgpt4oモデルでも全ての質問で正解を出力していました。

この検証から、

内在的ハルシネーションを発生させるのは意外と容易であること、

順位が関連すると対象をうまく比較できないのか、回答精度が落ちることがわかりました。

精度が高い情報を取得しようと思ったらプロンプトエンジニアリングを行ったほうが良いようです。

終わりに

外在的ハルシネーションについては別の機会に試してみたいと思います。

みなさんも生成AIを用いて内在的ハルシネーションや外在的ハルシネーションを発生させてみてください。