- 趣味

スマホでSLM(小規模言語モデル)を実際に動かしてみました|TinySwallow-1.5Bレビュー

AIxRチーム O.Kyoyaです。

本日は、SakanaAI社から新たに発表された日本語の小規模言語モデル(SLM)「TinySwallow-1.5B」を実際にスマートフォンで動かしてみましたので、そのレビューと新技術「TAID」について紹介します。https://sakana.ai/taid-jp/

本記事の目次

- スマホで「TinySwallow-1.5B」を実際に動かしてみた

- 新手法「TAID」とは?TinySwallow-1.5Bの特徴

- まとめ

1.スマホで「TinySwallow-1.5B」を実際に動かしてみた

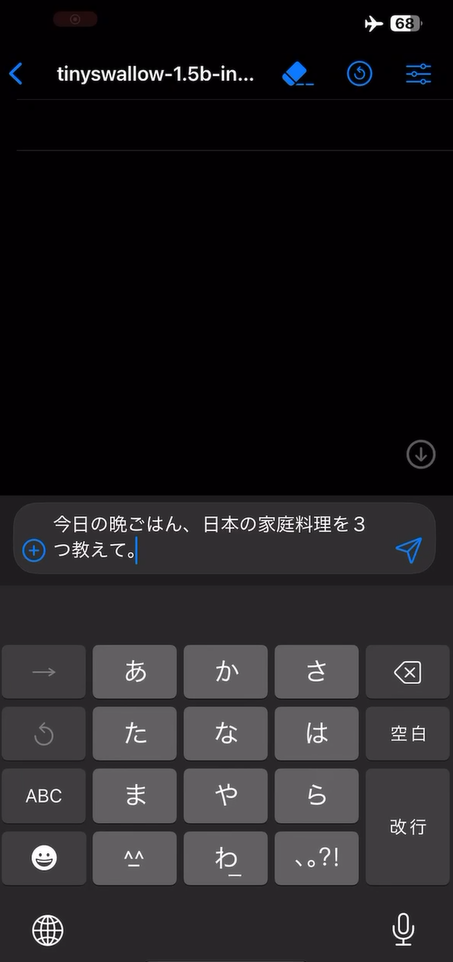

早速、手元のiPhoneで「TinySwallow-1.5B」をダウンロードして、動かしてみました。

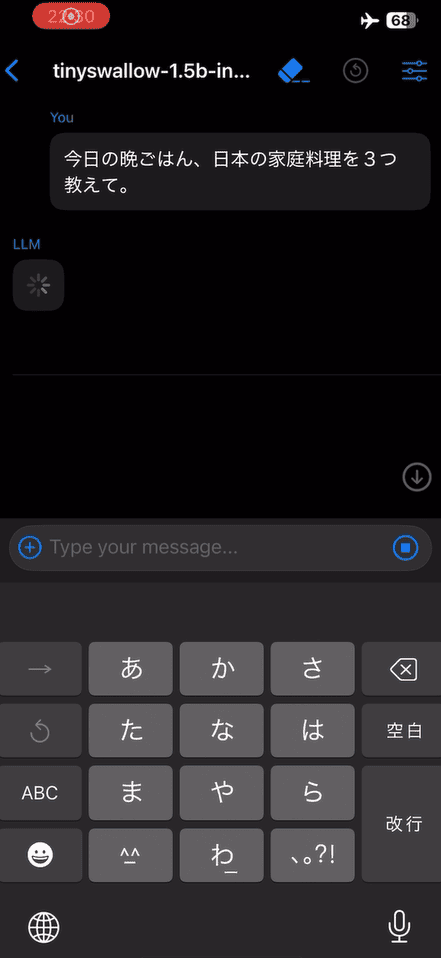

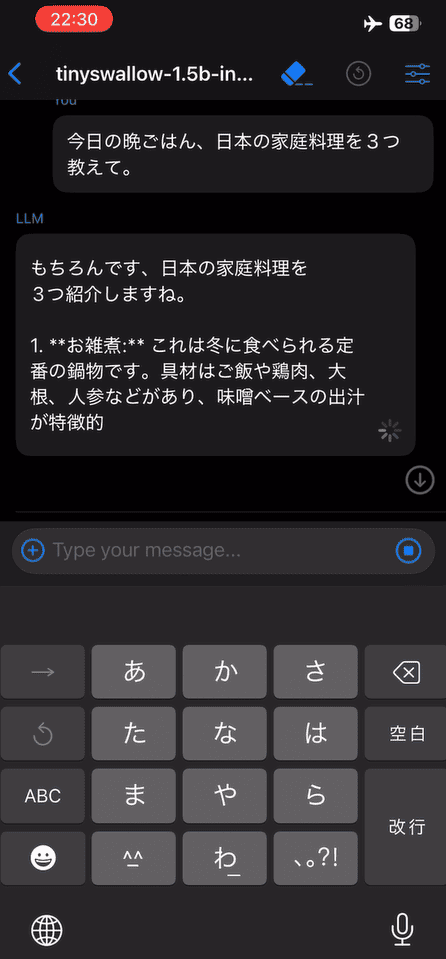

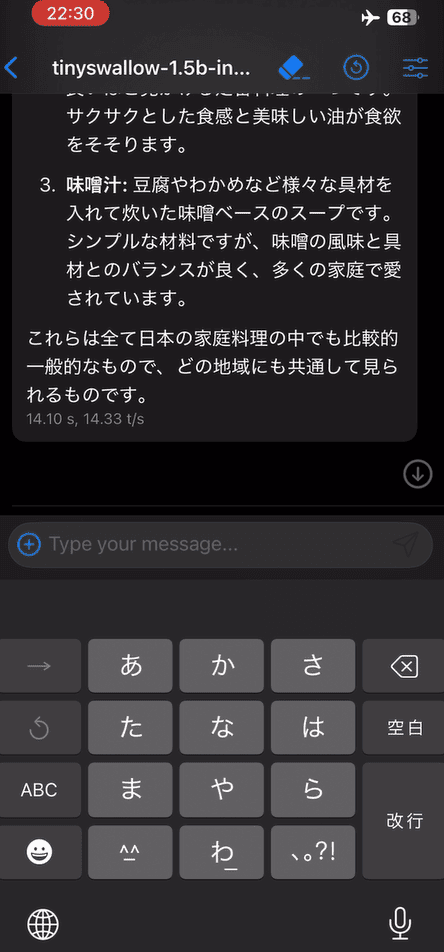

完全オフラインで動作可能なため、スマホを機内モードにしても利用できるという利便性は大きなメリットです。

実際の動作状況は以下の画像をご覧ください。

ダウンロードから設定まで、特別な専門知識がなくても5~10分程度で簡単にセットアップが完了しました。

実際にオフラインで動作している画面をご覧ください。

【ダウンロード手順】

- アプリのダウンロード

- モデルファイルのダウンロード

- LLMFarmでの設定

- 追加設定(任意)

詳細な手順はこちらのGitHubをご覧ください。GitHubの手順書(公式)

2.新手法「TAID」とは?TinySwallow-1.5Bの特徴

「TinySwallow-1.5B」はLLMの知識をSLMへ効率よく転移させる「知識蒸留」の新たな手法である「TAID (Temporally Adaptive Interpolated Distillation)」を採用しています。

TAIDの特徴

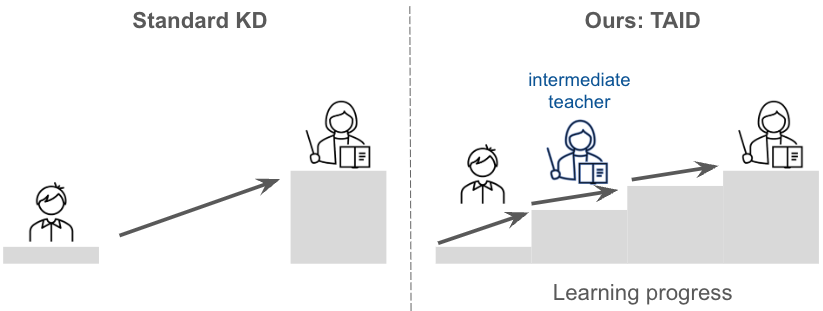

- 従来の手法では、大型言語モデル(LLM)の性能が高すぎると、小規模モデル(SLM)への知識転移が困難でした(例:大学院生レベルの知識を小学生に教える難しさ)。

- TAIDでは、教師モデルと生徒モデルの中間に「中間教師」を導入することで、生徒モデルの学習段階に合わせて適切な知識レベルを提供し、効率的な学習を実現します。

TinySwallow-1.5Bの主な特徴

- Googleの「Gemma」をベースに日本語で学習したモデル

- 日本語LLMベンチマークにおいて、同規模のモデル中で最高水準の性能を達成

3.まとめ

「TinySwallow-1.5B」の主なメリットは以下の通りです。

- 完全オフラインでスマホやPCで動作

- クラウドを使用しないため、機密情報を外部に送信したくない場合にも最適

- TAIDによって、小規模ながら高性能な日本語理解・生成を実現

SLMを段階的に教育するというTAIDの考え方は、学校教育に例えると非常に理解しやすく斬新でした。

今後も新しい生成AIツールを試しながら、それぞれの特徴や強みを明確に整理し、情報を共有してまいります。